Cảnh giác hành vi ghép mặt, giọng nói giống hệt người thân để lừa đảo

Thứ năm, 30/03/2023

Người dùng cần cảnh giác trước hành vi lừa đảo khi các đối tượng sử dụng công nghệ Deepfake AI để tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video với độ chính xác cao.

Các đối tượng tội phạm công nghệ cao sử dụng Deepfake AI để ghép mặt và giọng nói giống hệt người thân của nạn nhân để lừa đảo. Với cách thức này, gần đây chúng đã đánh lừa một nạn nhân ở TP.HCM với số tiền 20 triệu đồng, ngay cả khi nạn nhân đã thực hiện cuộc gọi video qua Facebook để kiểm chứng.

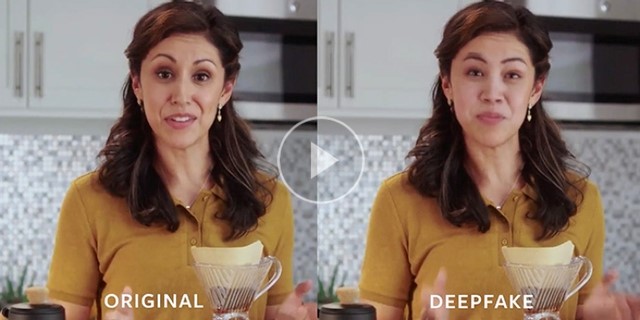

Một hình ảnh do Deepfake tạo ra (phải) trông rất giống người thật. Chụp màn hình

Trước đó, Công an tỉnh Tuyên Quang cho biết các tội phạm công nghệ cao đang bắt đầu sử dụng trí tuệ nhân tạo (AI) để thực hiện các hành vi lừa đảo chiếm đoạt tài sản rất tinh vi. Chúng sử dụng công nghệ Deepfake AI để tạo ra các sản phẩm công nghệ âm thanh, hình ảnh và video với độ chính xác cao, từ đó thực hiện cuộc gọi video để giả làm người thân vay tiền cho những tình huống cấp bách cần tiền gấp.

Nhằm phục vụ trò lừa đảo, chúng tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói được đăng tải công khai trên các tài khoản mạng xã hội… rồi sử dụng công nghệ Deepfake để tạo sẵn những video rất khó phân biệt thật - giả, có hình ảnh, giọng nói của cá nhân đó để phục vụ cho kịch bản lừa đảo. Những cuộc gọi video như vậy thường có âm thanh không rõ nét, tín hiệu chập chờn giống cuộc gọi trong vùng phủ sóng yếu để nạn nhân khó phân biệt thật giả. Nếu nạn nhân cẩn thận gọi video lại để kiểm chứng, chúng sẽ không nhận cuộc gọi hoặc sử dụng phần mềm cắt ghép hình ảnh, video để đánh lừa.

Dựa vào cách thức này, mọi người được khuyến cáo nâng cao cảnh giác, khi nhận bất kỳ tin nhắn, cuộc gọi video với nội dung vay, mượn tiền qua các ứng dụng mạng xã hội. Tốt hơn hết, hãy bình tĩnh gọi điện thoại trực tiếp cho người thân để xác minh mà không qua các ứng dụng như Zalo, Messenger, Viber, Telegram… Trong trường hợp nghi vấn hãy báo ngay cho cơ quan công an gần nhất để được hỗ trợ và xử lý kịp thời.

Về cơ chế hoạt động, Deepfake AI sử dụng kỹ thuật trí tuệ nhân tạo tiên tiến thu thập dữ liệu về chuyển động vật lý, đặc điểm khuôn mặt và thậm chí cả giọng nói, rồi xử lý thông qua thuật toán mã hóa AI hoặc Mạng đối kháng tạo sinh (GAN), để tạo ra âm thanh, hình ảnh giả nhưng vô cùng giống thực.

Đây không phải là công nghệ hoàn toàn mới. Trên thực tế, nó đã được sử dụng trong nhiều năm ở các hãng phim Hollywood, nhưng hiện trở nên phổ biến thông qua các ứng dụng thương mại. Nội dung này tăng nhiều đến mức Facebook đã cấm Deepfake vào năm 2020.

Trong một vụ lừa đảo đặc biệt nghiêm trọng, những kẻ đe dọa đã gửi thư thoại mô phỏng giọng nói của một CEO, yêu cầu nhân viên đóng góp cho các hoạt động từ thiện, cứu trợ thiên tai thông qua các trang web giả mạo để chuyển tiền vào các tài khoản ở nước ngoài.

Theo các chuyên gia bảo mật, để có thể kiểm tra phía bên gọi có sử dụng Deepfake AI để giả mạo trong những cuộc gọi video hay không, hãy yêu cầu họ quay mặt sang bên các góc 90 độ, thì còn có một phương pháp nhỏ đó là yêu cầu họ đưa tay trước mặt. Khi đưa tay lên khuôn mặt, sự chồng chéo của bàn tay và khuôn mặt khiến AI bị nhầm lẫn, thao tác này thường được gọi là "tạo mặt nạ" hoặc "xóa nền".

Hiện tại trên các diễn đàn tin tặc, tình trạng mua bán dữ liệu người dùng đang diễn ra rất phức tạp. Các dữ liệu nhạy cảm như KYC (Know Your Customer), eKYC - dữ liệu để xác minh thông tin người dùng bao gồm cả video khuôn mặt, ghi âm giọng nói… là nguồn dữ liệu phong phú để Deepfake có thể khai tác trong việc huấn luyện AI phục vụ cho các mục đích xấu của tin tặc.

Theo Thanh niên

Tags

Bài viết cùng chuyên mục

- Bộ KH&CN công bố danh mục 21 bài toán lớn về KHCN, đổi mới sáng tạo và chuyển đổi số

- Sản xuất nước mắm bằng năng lượng mặt trời năng suất tăng 20%

- Điều gì đó ẩn sâu trong thế giới lượng tử

- Lò phản ứng hạt nhân Việt Nam và mong mỏi của chuyên gia y học

- Nuôi cua lột trong hộp nhựa thu lãi sau 6 đến 8 tháng

- LNG – Tương lai của ngành năng lượng Việt Nam

- Tìm ra công nghệ pin vĩnh cửu, không gây ô nhiễm

- GPT-5 sẽ sở hữu trí thông minh của một tiến sĩ

- Có rừng là có tín chỉ carbon?

- Học sinh biến rác thải nhựa thành chất đốt

.jpg)

.png)

.jpg)

Đăng nhập để gửi bình luận

Bình luận